Discriminatie in AI-wervingsinstrumenten aanpakken: FINDHR presenteert nieuwe oplossingen

21 January 2026

Bewezen risico's van discriminatie bij AI-ondersteunde werving

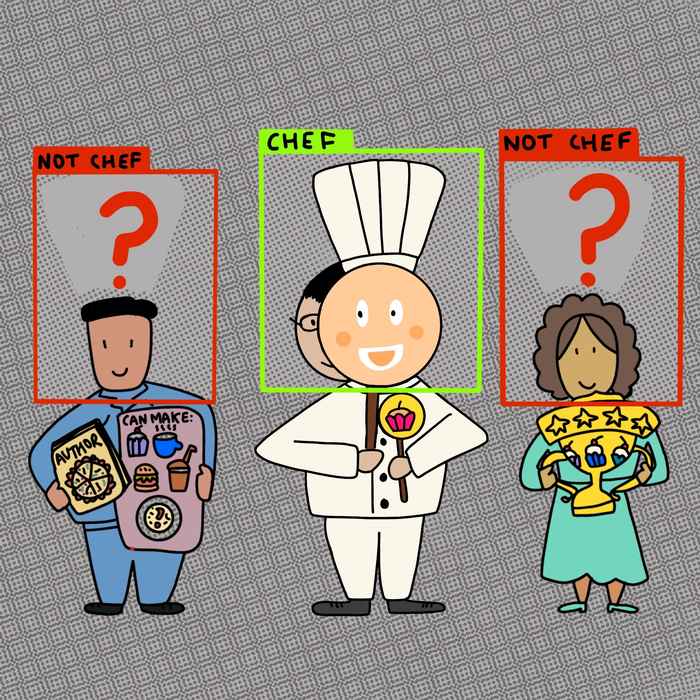

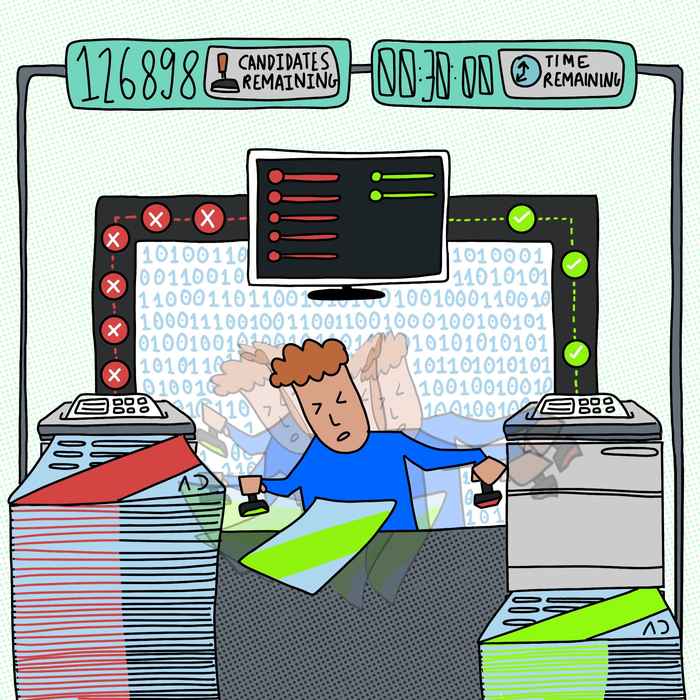

AI-ondersteunde wervingssystemen beloven tijdwinst voor HR-professionals. De praktijk leert echter dat deze systemen bestaande discriminatiepatronen kunnen versterken – of nieuwe kunnen creëren – vaak zonder dat de gebruikers zich daarvan bewust zijn. Het FINDHR-project richt zich met name op intersectionele discriminatie, waarbij combinaties van persoonlijke kenmerken (zoals geslacht, leeftijd, religie, afkomst of seksuele geaardheid) nieuwe of meerdere vormen van discriminatie genereren.

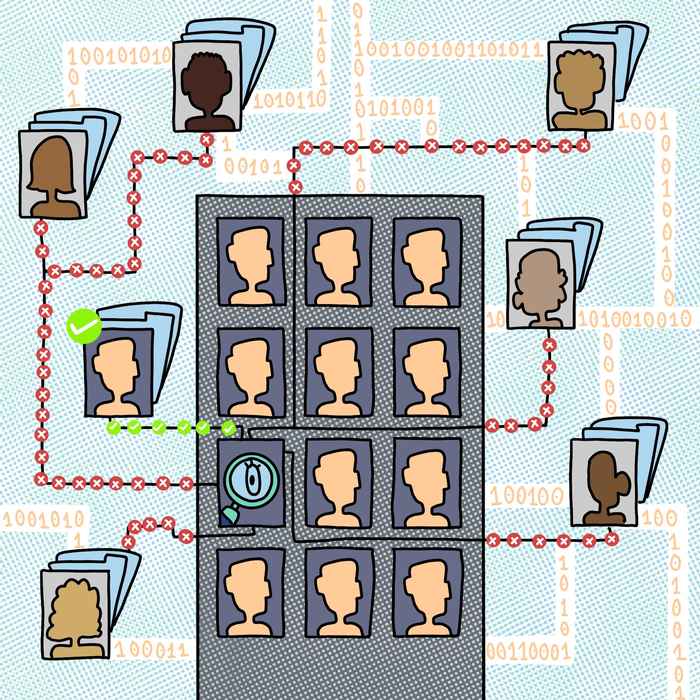

Het onderzoek toont aan dat discriminatie bij geautomatiseerde werving geen theoretisch probleem is, maar voor velen een dagelijkse realiteit. Uit interviews met betrokken personen in zeven Europese landen (Albanië, Bulgarije, Duitsland, Griekenland, Italië, Nederland en Servië) bleek dat sollicitanten zich machteloos en gefrustreerd voelden, omdat sollicitanten ondanks hun uitstekende kwalificaties en herhaalde sollicitaties vaak alleen buiten kantooruren een geautomatiseerde afwijzing ontvingen.

Eerlijkheid inbouwen in AI-wervingssystemen

Deze ervaringen vormen het uitgangspunt voor het technische en praktische werk van het project. Bij IRLab hebben de onderzoekers zich gericht op het inbouwen van eerlijkheid en non-discriminatie in het ontwerp van rangschikkings- en aanbevelingsalgoritmen die bij werving worden gebruikt.

Als medewerker van het IRLab heb ik beoordeeld welke eerlijkheidsmethoden in algoritmische wervingssystemen bruikbaar zijn bij werving. Bij het ontwikkelen van eerlijkheidsbewuste en robuuste methoden voor het leren rangschikken heb ik me vooral gericht op kandidaten die tot meerdere minderheidsgroepen behoren. Daarnaast heb ik bijgedragen aan de Software Development Guide, waarin wordt uitgelegd hoe menselijke aanbevelingssystemen kunnen worden ontworpen en geïmplementeerd die voldoen aan de wettelijke vereisten en de beginselen van eerlijkheid en transparantie hooghouden.Clara Rus - PhD candidate at IRLab

FINDHR Tools en oplossingen

Op basis van deze bevindingen en technische inzichten hebben onderzoekers hun resultaten en aanbevelingen gebundeld in uitgebreide toolkits, richtlijnen en technische hulpmiddelen. Iedereen heeft toegang tot de volgende gratis beschikbare, Engelsatige bronnen van FINDHR.

Werkzoekenden

Beleidsmakers

Productmanagers en algoritmische auditors

Wervingsprofessionals

Software developers

Over het FINDHR project

Het FINDHR-project vertegenwoordigt een uitgebreide, interdisciplinaire aanpak om AI-wervingssystemen eerlijker, verantwoordelijker en transparanter te maken. Meer informatie vind je op de FINDHR website.